售前咨询

快手万擎(Vanchin)

模型量化

更新时间:2025-12-30 19:59:56

模型量化是指在不严重损失模型精度的情况下,将模型中连续、高精度的数值(通常是32位浮点数)转换为离散、低精度的数值(如8位整数),从而大幅减少模型对存储和计算资源的需求,并提升推理速度。平台当前支持支持 AWQ 和 GPTQ 两种主流的训练后量化方法,使您能在保持模型核心能力的前提下,实现高效的模型部署。

核心价值:

- 内存节省:模型大小在量化后降低,所需存储空间减少,部署所需资源减少。

- 推理加速:模型推理吞吐提升,模型推理速度提升。

- 质量保持:通过先进算法,在精度损失极小的情况下完成压缩。

量化介绍

量化方式

- AWQ:4bit量化权重,逐张量量化,基于激活值分布挑选显著权重,针对重要权重增加筛选和保护机制,适用于在小显存GPU部署场景。

- GPTQ:8bit量化权重和激活值,逐张量量化,通过逐行量化权重矩阵来压缩模型,适用于最求精度的同时提高推理性能。

量化位宽

- AWQ:W4A16,即权重Weight-int4,激活Activation-int16

- GPTQ:Wfp8Afp8,即权重Weight-fp8,激活Activation-fp8

支持量化的模型类型

- 预置模型:支持用户选择万擎平台提供的基础模型进行量化后部署;

- 定制模型:支持用户选择微调过的模型进行量化后部署,当前暂不支持选择用户自主上传模型。

操作说明

创建量化任务

左侧导航页选择模型定制 - 模型量化,点击「新建量化任务」,进入新建量化任务页面:

- 填写任务名称、描述;

- 选择需进行量化的模型,当前支持平台预置模型及用户微调后模型,暂不支持上传模型;

- 选择量化方式,量化位宽将根据您选择的量化方式自动填充;

- 选择数据集,若量化来源为微调后的模型,则默认填充微调的数据集,您可选择切换为其他数据集;

- 选择发布方式并完成基础信息填写。

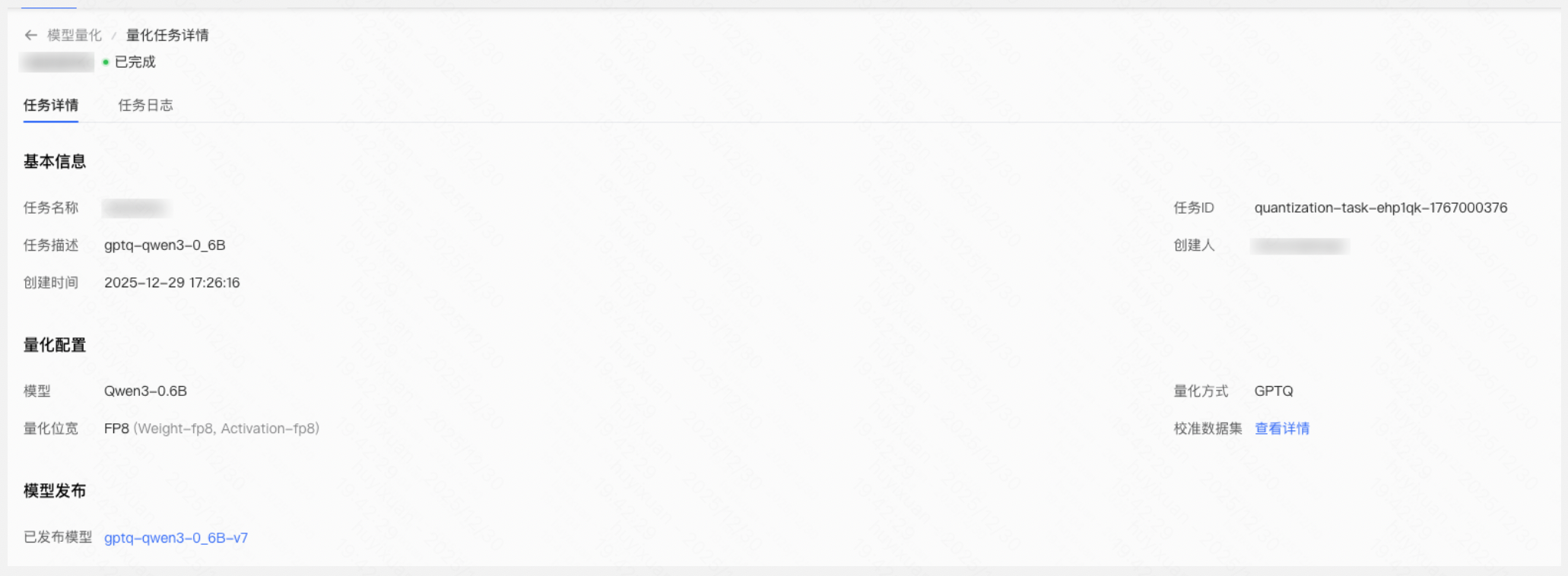

查看量化任务

当项目下存在量化任务时,用户可在模型量化页面查看该项目下的所有量化任务信息,点击某个任务名称将进入该任务详情,可查看任务的详情信息及任务日志。